大模型应用开发框架LangChain

1、Model I/O

Model I/O是 LangChain 为开发者提供的一套面向 LLM 的标准化模型接口,包括模型输入(Prompts)、模型输出(Output Parsers)和模型本身(Models)。- Prompts:模板化、动态选择和管理模型输入。

- Models:以通用接口调用语言模型。

- Output Parser:从模型输出中提取信息,并规范化内容。

![image-20250602124247309]()

1.1 模型Model

- 模型抽象Model:

语言模型(LLMs): LangChain 的核心组件。LangChain并不提供自己的LLMs,而是为与许多不同的LLMs(OpenAI、Cohere、Hugging Face等)进行交互提供了一个标准接口。

聊天模型(Chat Models): 语言模型的一种变体。虽然聊天模型在内部使用了语言模型,但它们提供的接口略有不同。与其暴露一个“输入文本,输出文本”的API不同,它们提供了一个以“聊天消息”作为输入和输出的接口。

1.1.1 语言模型(LLMs)

类继承关系:BaseLanguageModel –> BaseLLM –> LLM –> <name> # Examples: AI21, HuggingFaceHub, OpenAI

主要抽象:LLMResult, PromptValue, CallbackManagerForLLMRun, AsyncCallbackManagerForLLMRun, CallbackManager, AsyncCallbackManager, AIMessage, BaseMessage

https://api.python.langchain.com/en/latest/langchain_api_reference.html

源码解析

BaseLanguageModel Class:这个基类为语言模型定义了一个接口,该接口允许用户以不同的方式与模型交互(例如通过提示或消息)。

generate_prompt是其中的一个主要方法,它接受一系列提示,并返回模型的生成结果。(代码实现:https://github.com/langchain-ai/langchain/blob/master/libs/langchain/langchain/schema/language_model.py)1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45# 定义 BaseLanguageModel 抽象基类,它从 Serializable, Runnable 和 ABC 继承

class BaseLanguageModel(

Serializable, Runnable[LanguageModelInput, LanguageModelOutput], ABC

):

"""

与语言模型交互的抽象基类。

所有语言模型的封装器都应从 BaseLanguageModel 继承。

主要提供三种方法:

- generate_prompt: 为一系列的提示值生成语言模型输出。提示值是可以转换为任何语言模型输入格式的模型输入(如字符串或消息)。

- predict: 将单个字符串传递给语言模型并返回字符串预测。

- predict_messages: 将一系列 BaseMessages(对应于单个模型调用)传递给语言模型,并返回 BaseMessage 预测。

每种方法都有对应的异步方法。

"""

# 定义一个抽象方法 generate_prompt,需要子类进行实现

def generate_prompt(

self,

prompts: List[PromptValue], # 输入提示的列表

stop: Optional[List[str]] = None, # 生成时的停止词列表

callbacks: Callbacks = None, # 回调,用于执行例如日志记录或流式处理的额外功能

**kwargs: Any, # 任意的额外关键字参数,通常会传递给模型提供者的 API 调用

) -> LLMResult:

"""

将一系列的提示传递给模型并返回模型的生成。

对于提供批处理 API 的模型,此方法应使用批处理调用。

使用此方法时:

1. 希望利用批处理调用,

2. 需要从模型中获取的输出不仅仅是最顶部生成的值,

3. 构建与底层语言模型类型无关的链(例如,纯文本完成模型与聊天模型)。

参数:

prompts: 提示值的列表。提示值是一个可以转换为与任何语言模型匹配的格式的对象(对于纯文本生成模型为字符串,对于聊天模型为 BaseMessages)。

stop: 生成时使用的停止词。模型输出在这些子字符串的首次出现处截断。

callbacks: 要传递的回调。用于执行额外功能,例如在生成过程中进行日志记录或流式处理。

**kwargs: 任意的额外关键字参数。通常这些会传递给模型提供者的 API 调用。

返回值:

LLMResult,它包含每个输入提示的候选生成列表以及特定于模型提供者的额外输出。

"""BaseLLM Class:这段代码定义了一个名为 BaseLLM 的抽象基类。这个基类的主要目的是提供一个基本的接口来处理大型语言模型 (LLM),使用了 Pydantic 的功能,特别是 Field 方法,用于定义默认值和序列化行为。BaseLLM 的子类需要提供实现具体功能的方法。。(代码实现:https://github.com/langchain-ai/langchain/blob/master/libs/langchain/langchain/llms/base.py)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34# 定义 BaseLLM 抽象基类,它从 BaseLanguageModel[str] 和 ABC(Abstract Base Class)继承

class BaseLLM(BaseLanguageModel[str], ABC):

"""Base LLM abstract interface.

It should take in a prompt and return a string."""

# 定义可选的缓存属性,其初始值为 None

cache: Optional[bool] = None

# 定义 verbose 属性,该属性决定是否打印响应文本

# 默认值使用 _get_verbosity 函数的结果

verbose: bool = Field(default_factory=_get_verbosity)

"""Whether to print out response text."""

# 定义 callbacks 属性,其初始值为 None,并从序列化中排除

callbacks: Callbacks = Field(default=None, exclude=True)

# 定义 callback_manager 属性,其初始值为 None,并从序列化中排除

callback_manager: Optional[BaseCallbackManager] = Field(default=None, exclude=True)

# 定义 tags 属性,这些标签会被添加到运行追踪中,其初始值为 None,并从序列化中排除

tags: Optional[List[str]] = Field(default=None, exclude=True)

"""Tags to add to the run trace."""

# 定义 metadata 属性,这些元数据会被添加到运行追踪中,其初始值为 None,并从序列化中排除

metadata: Optional[Dict[str, Any]] = Field(default=None, exclude=True)

"""Metadata to add to the run trace."""

# 内部类定义了这个 pydantic 对象的配置

class Config:

"""Configuration for this pydantic object."""

# 允许使用任意类型

arbitrary_types_allowed = TrueLLM Class:这段代码定义了一个名为 LLM 的类,该类继承自 BaseLLM。这个类的目的是为了为用户提供一个简化的接口来处理LLM(大型语言模型),而不期望用户实现完整的 _generate 方法。(代码实现:https://github.com/langchain-ai/langchain/blob/master/libs/langchain/langchain/llms/base.py)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44# 继承自 BaseLLM 的 LLM 类

class LLM(BaseLLM):

"""Base LLM abstract class.

The purpose of this class is to expose a simpler interface for working

with LLMs, rather than expect the user to implement the full _generate method.

"""

# 使用 @abstractmethod 装饰器定义一个抽象方法,子类需要实现这个方法

def _call(

self,

prompt: str, # 输入提示

stop: Optional[List[str]] = None, # 停止词列表

run_manager: Optional[CallbackManagerForLLMRun] = None, # 运行管理器

**kwargs: Any, # 其他关键字参数

) -> str:

"""Run the LLM on the given prompt and input."""

# 此方法的实现应在子类中提供

# _generate 方法使用了 _call 方法,用于处理多个提示

def _generate(

self,

prompts: List[str], # 多个输入提示的列表

stop: Optional[List[str]] = None,

run_manager: Optional[CallbackManagerForLLMRun] = None,

**kwargs: Any,

) -> LLMResult:

"""Run the LLM on the given prompt and input."""

# TODO: 在此处添加缓存逻辑

generations = [] # 用于存储生成的文本

# 检查 _call 方法的签名是否支持 run_manager 参数

new_arg_supported = inspect.signature(self._call).parameters.get("run_manager")

for prompt in prompts: # 遍历每个提示

# 根据是否支持 run_manager 参数来选择调用方法

text = (

self._call(prompt, stop=stop, run_manager=run_manager, **kwargs)

if new_arg_supported

else self._call(prompt, stop=stop, **kwargs)

)

# 将生成的文本添加到 generations 列表中

generations.append([Generation(text=text)])

# 返回 LLMResult 对象,其中包含 generations 列表

return LLMResult(generations=generations)LLMs已支持模型清单:

使用 LangChain 调用 OpenAI GPT Completion API

BaseOpenAI Class:(代码实现:https://github.com/langchain-ai/langchain/blob/master/libs/langchain/langchain/llms/openai.py)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57class BaseOpenAI(BaseLLM):

"""OpenAI 大语言模型的基类。"""

def lc_secrets(self) -> Dict[str, str]:

return {"openai_api_key": "OPENAI_API_KEY"}

def lc_serializable(self) -> bool:

return True

client: Any #: :meta private:

model_name: str = Field("text-davinci-003", alias="model")

"""使用的模型名。"""

temperature: float = 0.7

"""要使用的采样温度。"""

max_tokens: int = 256

"""完成中生成的最大令牌数。

-1表示根据提示和模型的最大上下文大小返回尽可能多的令牌。"""

top_p: float = 1

"""在每一步考虑的令牌的总概率质量。"""

frequency_penalty: float = 0

"""根据频率惩罚重复的令牌。"""

presence_penalty: float = 0

"""惩罚重复的令牌。"""

n: int = 1

"""为每个提示生成多少完成。"""

best_of: int = 1

"""在服务器端生成best_of完成并返回“最佳”。"""

model_kwargs: Dict[str, Any] = Field(default_factory=dict)

"""保存任何未明确指定的`create`调用的有效模型参数。"""

openai_api_key: Optional[str] = None

openai_api_base: Optional[str] = None

openai_organization: Optional[str] = None

# 支持OpenAI的显式代理

openai_proxy: Optional[str] = None

batch_size: int = 20

"""传递多个文档以生成时使用的批处理大小。"""

request_timeout: Optional[Union[float, Tuple[float, float]]] = None

"""向OpenAI完成API的请求超时。 默认为600秒。"""

logit_bias: Optional[Dict[str, float]] = Field(default_factory=dict)

"""调整生成特定令牌的概率。"""

max_retries: int = 6

"""生成时尝试的最大次数。"""

streaming: bool = False

"""是否流式传输结果。"""

allowed_special: Union[Literal["all"], AbstractSet[str]] = set()

"""允许的特殊令牌集。"""

disallowed_special: Union[Literal["all"], Collection[str]] = "all"

"""不允许的特殊令牌集。"""

tiktoken_model_name: Optional[str] = None

"""使用此类时传递给tiktoken的模型名。

Tiktoken用于计算文档中的令牌数量以限制它们在某个限制以下。

默认情况下,设置为None时,这将与嵌入模型名称相同。

但是,在某些情况下,您可能希望使用此嵌入类与tiktoken不支持的模型名称。

这可以包括使用Azure嵌入或使用多个模型提供商的情况,这些提供商公开了类似OpenAI的API但模型不同。

在这些情况下,为了避免在调用tiktoken时出错,您可以在此处指定要使用的模型名称。"""OpenAI LLM 模型默认使用 gpt-3.5-turbo-instruct:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19from langchain_openai import OpenAI

llm = OpenAI(model_name="gpt-3.5-turbo-instruct")

print(llm.invoke("Tell me a Joke")) # Why couldn't the bicycle stand up by itself? Because it was two-tired!

print(llm.invoke("讲10个给程序员听得笑话"))

# 1. 为什么程序员总是喜欢用黑色主题?因为黑色主题更酷,而且能节省电。

# 2. 为什么程序员总是担心世界末日?因为那时候所有的代码都会变成bug。

# 3. 为什么程序员经常在夜里工作?因为他们觉得夜晚是最好的调试时间,因为所有的bug都会藏在黑暗中。

# 4. 什么是程序员最害怕的字?“404 Not Found”。

# 5. 为什么程序员总是喜欢喝咖啡?因为咖啡是唯一能让他们保持清醒的东西。

# 6. 为什么程序员总是喜欢用英文命名变量?因为他们觉得英文变量名看起来更专业,而且可以避免一些中文编码

# 生成10个笑话,显然超过了 max_token 默认值

llm.max_tokens # 256

# 修改 max_token 值为 1024

llm.max_tokens = 1024

llm.max_tokens # 1024对比直接调用 OpenAI API:

1

2

3

4

5

6

7

8from openai import OpenAI

client = OpenAI()

data = client.completions.create(

model="gpt-3.5-turbo-instruct",

prompt="Tell me a Joke",

)

1.1.2 聊天模型(Chat Models)

- 类继承关系:BaseLanguageModel –> BaseChatModel –> <name> # Examples: ChatOpenAI, ChatGooglePalm

- 主要抽象:AIMessage, BaseMessage, HumanMessage

源码解析

BaseChatModel Class:(代码实现:https://github.com/langchain-ai/langchain/blob/master/libs/langchain/langchain/chat_models/base.py)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23class BaseChatModel(BaseLanguageModel[BaseMessageChunk], ABC):

cache: Optional[bool] = None

"""是否缓存响应。"""

verbose: bool = Field(default_factory=_get_verbosity)

"""是否打印响应文本。"""

callbacks: Callbacks = Field(default=None, exclude=True)

"""添加到运行追踪的回调函数。"""

callback_manager: Optional[BaseCallbackManager] = Field(default=None, exclude=True)

"""添加到运行追踪的回调函数管理器。"""

tags: Optional[List[str]] = Field(default=None, exclude=True)

"""添加到运行追踪的标签。"""

metadata: Optional[Dict[str, Any]] = Field(default=None, exclude=True)

"""添加到运行追踪的元数据。"""

# 需要子类实现的 _generate 抽象方法

def _generate(

self,

messages: List[BaseMessage],

stop: Optional[List[str]] = None,

run_manager: Optional[CallbackManagerForLLMRun] = None,

**kwargs: Any,

) -> ChatResult:ChatOpenAI Class(调用 Chat Completion API):(代码实现:https://github.com/langchain-ai/langchain/blob/master/libs/langchain/langchain/chat_models/openai.py)

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52class ChatOpenAI(BaseChatModel):

"""OpenAI Chat大语言模型的包装器。

要使用,您应该已经安装了``openai`` python包,并且

环境变量``OPENAI_API_KEY``已使用您的API密钥进行设置。

即使未在此类上明确保存,也可以传入任何有效的参数

至openai.create调用。

"""

def lc_secrets(self) -> Dict[str, str]:

return {"openai_api_key": "OPENAI_API_KEY"}

def lc_serializable(self) -> bool:

return True

client: Any = None #: :meta private:

model_name: str = Field(default="gpt-3.5-turbo", alias="model")

"""要使用的模型名。"""

temperature: float = 0.7

"""使用的采样温度。"""

model_kwargs: Dict[str, Any] = Field(default_factory=dict)

"""保存任何未明确指定的`create`调用的有效模型参数。"""

openai_api_key: Optional[str] = None

"""API请求的基础URL路径,

如果不使用代理或服务仿真器,请留空。"""

openai_api_base: Optional[str] = None

openai_organization: Optional[str] = None

# 支持OpenAI的显式代理

openai_proxy: Optional[str] = None

request_timeout: Optional[Union[float, Tuple[float, float]]] = None

"""请求OpenAI完成API的超时。默认为600秒。"""

max_retries: int = 6

"""生成时尝试的最大次数。"""

streaming: bool = False

"""是否流式传输结果。"""

n: int = 1

"""为每个提示生成的聊天完成数。"""

max_tokens: Optional[int] = None

"""生成的最大令牌数。"""

tiktoken_model_name: Optional[str] = None

"""使用此类时传递给tiktoken的模型名称。

Tiktoken用于计算文档中的令牌数以限制

它们在某个限制之下。默认情况下,当设置为None时,这将

与嵌入模型名称相同。但是,在某些情况下,

您可能希望使用此嵌入类,模型名称不

由tiktoken支持。这可能包括使用Azure嵌入或

使用其中之一的多个模型提供商公开类似OpenAI的

API但模型不同。在这些情况下,为了避免在调用tiktoken时出错,

您可以在这里指定要使用的模型名称。"

使用 LangChain 调用 OpenAI GPT ChatCompletion API

案例如下:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21from langchain_openai import ChatOpenAI

chat_model = ChatOpenAI(model_name="gpt-3.5-turbo")

from langchain.schema import (

AIMessage,

HumanMessage,

SystemMessage

)

messages = [SystemMessage(content="You are a helpful assistant."),

HumanMessage(content="Who won the world series in 2020?"),

AIMessage(content="The Los Angeles Dodgers won the World Series in 2020."),

HumanMessage(content="Where was it played?")]

print(messages) # [SystemMessage(content='You are a helpful assistant.'), HumanMessage(content='Who won the world series in 2020?'), AIMessage(content='The Los Angeles Dodgers won the World Series in 2020.'), HumanMessage(content='Where was it played?')]

chat_model.invoke(messages) # AIMessage(content='The 2020 World Series was played at Globe Life Field in Arlington, Texas.', response_metadata={'token_usage': {'completion_tokens': 17, 'prompt_tokens': 53, 'total_tokens': 70}, 'model_name': 'gpt-3.5-turbo', 'system_fingerprint': None, 'finish_reason': 'stop', 'logprobs': None}, id='run-17b0f35a-460a-42f4-b7c9-1b6fa2871416-0')

chat_result = chat_model.invoke(messages)

type(chat_result) # langchain_core.messages.ai.AIMessage对比调用 OpenAI API:

1

2

3

4

5

6

7

8

9

10

11import openai

data = openai.ChatCompletion.create(

model="gpt-3.5-turbo",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Who won the world series in 2020?"},

{"role": "assistant", "content": "The Los Angeles Dodgers won the World Series in 2020."},

{"role": "user", "content": "Where was it played?"}

]

)

1.2 模型输入Prompts

- 一个语言模型的提示是用户提供的一组指令或输入,用于引导模型的响应,帮助它理解上下文并生成相关和连贯的基于语言的输出,例如回答问题、完成句子或进行对话。

- 提示模板(Prompt Templates):参数化的模型输入

- 示例选择器(Example Selectors):动态选择要包含在提示中的示例

1.2.1 提示模板Prompt Templates

Prompt Templates提供了一种预定义、动态注入、模型无关和参数化的提示词生成方式,以便在不同的语言模型之间重用模板。一个模板可能包括指令、少量示例以及适用于特定任务的具体背景和问题。通常,提示要么是一个字符串(LLMs),要么是一组聊天消息(Chat Model)。

类继承关系(代码实现:https://github.com/langchain-ai/langchain/blob/master/libs/langchain/langchain/prompts):

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15BasePromptTemplate --> PipelinePromptTemplate

StringPromptTemplate --> PromptTemplate

FewShotPromptTemplate

FewShotPromptWithTemplates

BaseChatPromptTemplate --> AutoGPTPrompt

ChatPromptTemplate --> AgentScratchPadChatPromptTemplate

BaseMessagePromptTemplate --> MessagesPlaceholder

BaseStringMessagePromptTemplate --> ChatMessagePromptTemplate

HumanMessagePromptTemplate

AIMessagePromptTemplate

SystemMessagePromptTemplate

PromptValue --> StringPromptValue

ChatPromptValue

使用 PromptTemplate 类生成提升词

通常,

PromptTemplate类的实例,使用Python的str.format语法生成模板化提示;也可以使用其他模板语法(例如jinja2)。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19from langchain import PromptTemplate

# 使用 from_template 方法实例化 PromptTemplate

prompt_template = PromptTemplate.from_template(

"Tell me a {adjective} joke about {content}."

)

# 使用 format 生成提示

prompt = prompt_template.format(adjective="funny", content="chickens")

print(prompt) # Tell me a funny joke about chickens.

print(prompt_template) # input_variables=['adjective', 'content'] input_types={} partial_variables={} template='Tell me a {adjective} joke about {content}.'

prompt_template = PromptTemplate.from_template(

"Tell me a joke"

)

# 生成提示

prompt = prompt_template.format()

print(prompt) # Tell me a joke

使用构造函数(Initializer)实例化 PromptTemplate

使用构造函数实例化

prompt_template时必须传入参数:input_variables和template。在生成提示过程中,会检查输入变量与模板字符串中的变量是否匹配,如果不匹配,则会引发异常。1

2

3

4invalid_prompt = PromptTemplate(

input_variables=["adjective"],

template="Tell me a {adjective} joke about {content}."

)传入 content 后才能生成可用的 prompt:

1

2

3

4

5

6

7valid_prompt = PromptTemplate(

input_variables=["adjective", "content"],

template="Tell me a {adjective} joke about {content}."

)

print(valid_prompt) # input_variables=['adjective', 'content'] input_types={} partial_variables={} template='Tell me a {adjective} joke about {content}.'

valid_prompt.format(adjective="funny", content="chickens") # 'Tell me a funny joke about chickens.'1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24from langchain_openai import OpenAI

llm = OpenAI(model_name="gpt-3.5-turbo-instruct", max_tokens=1000)

prompt_template = PromptTemplate.from_template(

"讲{num}个给程序员听得笑话"

)

prompt = prompt_template.format(num=2)

print(f"prompt: {prompt}") # prompt: 讲2个给程序员听得笑话

result = llm.invoke(prompt)

print(f"result: {result}") # result: content='当然可以!给程序员的笑话如下:\n\n1. 为什么程序员总是喜欢在洗手间里工作?\n 因为那里有很多“控制”流(control flow)!\n\n2. 有一天,一个程序员走进了酒吧,点了一杯啤酒。酒保问他:“要不要加点柠檬?”程序员回答:“不,我只想要最简单的‘Hello, World!’”\n\n希望这些笑话能让你会心一笑!' additional_kwargs={'refusal': None} response_metadata={'token_usage': {'completion_tokens': 106, 'prompt_tokens': 17, 'total_tokens': 123, 'completion_tokens_details': {'accepted_prediction_tokens': None, 'audio_tokens': None, 'reasoning_tokens': None, 'rejected_prediction_tokens': None}, 'prompt_tokens_details': {'audio_tokens': None, 'cached_tokens': None}}, 'model_name': 'gpt-4o-mini', 'system_fingerprint': 'fp_b705f0c291', 'finish_reason': 'stop', 'logprobs': None} id='run-3231f13c-95dc-4e93-ba30-3d5afdd03560-0' usage_metadata={'input_tokens': 17, 'output_tokens': 106, 'total_tokens': 123, 'input_token_details': {}, 'output_token_details': {}}

print(llm.invoke(prompt_template.format(num=3))) # content='当然可以!以下是三个适合程序员的笑话:\n\n1. **为什么程序员总是混淆万圣节和圣诞节?**\n 因为Oct 31 等于 Dec 25!\n\n2. **程序员的妻子对他生气了,问他为什么总是对代码那么上心。**\n 程序员回答:“因为它们比我们之间的沟通更容易调试!”\n\n3. **有什么是程序员最不喜欢的饮料?**\n 可乐,因为他们讨厌“糖”(bug)!\n\n希望你喜欢这些笑话!' additional_kwargs={'refusal': None} response_metadata={'token_usage': {'completion_tokens': 131, 'prompt_tokens': 17, 'total_tokens': 148, 'completion_tokens_details': {'accepted_prediction_tokens': None, 'audio_tokens': None, 'reasoning_tokens': None, 'rejected_prediction_tokens': None}, 'prompt_tokens_details': {'audio_tokens': None, 'cached_tokens': None}}, 'model_name': 'gpt-4o-mini', 'system_fingerprint': 'fp_b705f0c291', 'finish_reason': 'stop', 'logprobs': None} id='run-2f34ac13-aadf-451a-ad5e-942a36737161-0' usage_metadata={'input_tokens': 17, 'output_tokens': 131, 'total_tokens': 148, 'input_token_details': {}, 'output_token_details': {}}

# 【新增】ChatOpenAI调用方式,使用gpt-4o-mini模型

from langchain_openai import ChatOpenAI

llm = ChatOpenAI(model_name="gpt-4o-mini", max_tokens=1000)

prompt = prompt_template.format(num=2)

print(f"prompt: {prompt}")

result = llm.invoke(prompt)

print(f"result: {result}")1

2

3

4

5# 使用 jinja2 生成模板化提示

jinja2_template = "Tell me a {{ adjective }} joke about {{ content }}"

prompt = PromptTemplate.from_template(jinja2_template, template_format="jinja2")

prompt.format(adjective="funny", content="chickens") # 'Tell me a funny joke about chickens'

print(prompt) # input_variables=['adjective', 'content'] input_types={} partial_variables={} template='Tell me a {{ adjective }} joke about {{ content }}' template_format='jinja2'

实测:生成多种编程语言版本的快速排序

1 | sort_prompt_template = PromptTemplate.from_template( |

1.2.2 聊天模版ChatPromptTemplate

ChatPromptTemplate类的实例,使用format_messages方法生成适用于聊天模型的提示。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23from langchain.prompts import ChatPromptTemplate

from langchain_openai import ChatOpenAI

# 使用 from_messages 方法实例化 ChatPromptTemplate

template = ChatPromptTemplate.from_messages([

("system", "You are a helpful AI bot. Your name is {name}."),

("human", "Hello, how are you doing?"),

("ai", "I'm doing well, thanks!"),

("human", "{user_input}"),

])

# 生成提示

messages = template.format_messages(

name="Bob",

user_input="What is your name?"

)

print(messages) # [SystemMessage(content='You are a helpful AI bot. Your name is Bob.', additional_kwargs={}, response_metadata={}), HumanMessage(content='Hello, how are you doing?', additional_kwargs={}, response_metadata={}), AIMessage(content="I'm doing well, thanks!", additional_kwargs={}, response_metadata={}), HumanMessage(content='What is your name?', additional_kwargs={}, response_metadata={})]

print(messages[0].content) # You are a helpful AI bot. Your name is Bob.

print(messages[-1].content) # What is your name?

chat_model = ChatOpenAI(model_name="gpt-3.5-turbo", max_tokens=1000)

chat_model.invoke(messages) # AIMessage(content='My name is Bob.\n', additional_kwargs={'refusal': None}, response_metadata={'token_usage': {'completion_tokens': 6, 'prompt_tokens': 51, 'total_tokens': 57, 'completion_tokens_details': {'accepted_prediction_tokens': None, 'audio_tokens': 0, 'reasoning_tokens': None, 'rejected_prediction_tokens': None, 'text_tokens': 0}, 'prompt_tokens_details': {'audio_tokens': 0, 'cached_tokens': 0, 'text_tokens': 0, 'image_tokens': 0}}, 'model_name': 'gpt-3.5-turbo-0125', 'system_fingerprint': '', 'finish_reason': 'stop', 'logprobs': None}, id='run-56b4bc27-bb95-4687-87e1-001af8ff6f84-0', usage_metadata={'input_tokens': 51, 'output_tokens': 6, 'total_tokens': 57, 'input_token_details': {'audio': 0, 'cache_read': 0}, 'output_token_details': {'audio': 0}})

摘要总结案例

1 | from langchain_openai import ChatOpenAI |

1.2.3 示例模版FewShotPromptTemplate

构造 few-shot prompt 的方法通常有两种:

- 从示例集(set of examples)中手动选择;

- 通过示例选择器(Example Selector)自动选择。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88from langchain.prompts.prompt import PromptTemplate

examples = [

{

"question": "谁活得更久,穆罕默德·阿里还是艾伦·图灵?",

"answer":

"""

这里需要进一步的问题吗:是的。

追问:穆罕默德·阿里去世时多大了?

中间答案:穆罕默德·阿里去世时74岁。

追问:艾伦·图灵去世时多大了?

中间答案:艾伦·图灵去世时41岁。

所以最终答案是:穆罕默德·阿里

"""

},

{

"question": "craigslist的创始人是什么时候出生的?",

"answer":

"""

这里需要进一步的问题吗:是的。

追问:谁是craigslist的创始人?

中间答案:Craigslist是由Craig Newmark创办的。

追问:Craig Newmark是什么时候出生的?

中间答案:Craig Newmark出生于1952年12月6日。

所以最终答案是:1952年12月6日

"""

},

{

"question": "乔治·华盛顿的外祖父是谁?",

"answer":

"""

这里需要进一步的问题吗:是的。

追问:谁是乔治·华盛顿的母亲?

中间答案:乔治·华盛顿的母亲是Mary Ball Washington。

追问:Mary Ball Washington的父亲是谁?

中间答案:Mary Ball Washington的父亲是Joseph Ball。

所以最终答案是:Joseph Ball

"""

},

{

"question": "《大白鲨》和《皇家赌场》的导演是同一个国家的吗?",

"answer":

"""

这里需要进一步的问题吗:是的。

追问:谁是《大白鲨》的导演?

中间答案:《大白鲨》的导演是Steven Spielberg。

追问:Steven Spielberg来自哪里?

中间答案:美国。

追问:谁是《皇家赌场》的导演?

中间答案:《皇家赌场》的导演是Martin Campbell。

追问:Martin Campbell来自哪里?

中间答案:新西兰。

所以最终答案是:不是

"""

}

]

example_prompt = PromptTemplate(

input_variables=["question", "answer"],

template="Question: {question}\n{answer}"

)

# **examples[0] 是将examples[0] 字典的键值对(question-answer)解包并传递给format,作为函数参数

print(example_prompt.format(**examples[0]))

# Question: 谁活得更久,穆罕默德·阿里还是艾伦·图灵?

#

# 这里需要进一步的问题吗:是的。

# 追问:穆罕默德·阿里去世时多大了?

# 中间答案:穆罕默德·阿里去世时74岁。

# 追问:艾伦·图灵去世时多大了?

# 中间答案:艾伦·图灵去世时41岁。

# 所以最终答案是:穆罕默德·阿里

print(example_prompt) # input_variables=['answer', 'question'] input_types={} partial_variables={} template='Question: {question}\n{answer}'

print(example_prompt.format(**examples[-1]))

# Question: 《大白鲨》和《皇家赌场》的导演是同一个国家的吗?

#

# 这里需要进一步的问题吗:是的。

# 追问:谁是《大白鲨》的导演?

# 中间答案:《大白鲨》的导演是Steven Spielberg。

# 追问:Steven Spielberg来自哪里?

# 中间答案:美国。

# 追问:谁是《皇家赌场》的导演?

# 中间答案:《皇家赌场》的导演是Martin Campbell。

# 追问:Martin Campbell来自哪里?

# 中间答案:新西兰。

# 所以最终答案是:不是生成 Few-shot Prompt:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58# 导入 FewShotPromptTemplate 类

from langchain.prompts.few_shot import FewShotPromptTemplate

# 创建一个 FewShotPromptTemplate 对象

few_shot_prompt = FewShotPromptTemplate(

examples=examples, # 使用前面定义的 examples 作为范例

example_prompt=example_prompt, # 使用前面定义的 example_prompt 作为提示模板

suffix="Question: {input}", # 后缀模板,其中 {input} 会被替换为实际输入

input_variables=["input"] # 定义输入变量的列表

)

# 使用给定的输入格式化 prompt,并打印结果

# 这里的 {input} 将被 "玛丽·波尔·华盛顿的父亲是谁?" 替换

print(few_shot_prompt.format(input="玛丽·波尔·华盛顿的父亲是谁?"))

# Question: 谁活得更久,穆罕默德·阿里还是艾伦·图灵?

#

# 这里需要进一步的问题吗:是的。

# 追问:穆罕默德·阿里去世时多大了?

# 中间答案:穆罕默德·阿里去世时74岁。

# 追问:艾伦·图灵去世时多大了?

# 中间答案:艾伦·图灵去世时41岁。

# 所以最终答案是:穆罕默德·阿里

#

#

# Question: craigslist的创始人是什么时候出生的?

#

# 这里需要进一步的问题吗:是的。

# 追问:谁是craigslist的创始人?

# 中间答案:Craigslist是由Craig Newmark创办的。

# 追问:Craig Newmark是什么时候出生的?

# 中间答案:Craig Newmark出生于1952年12月6日。

# 所以最终答案是:1952年12月6日

#

#

# Question: 乔治·华盛顿的外祖父是谁?

#

# 这里需要进一步的问题吗:是的。

# 追问:谁是乔治·华盛顿的母亲?

# 中间答案:乔治·华盛顿的母亲是Mary Ball Washington。

# 追问:Mary Ball Washington的父亲是谁?

# 中间答案:Mary Ball Washington的父亲是Joseph Ball。

# 所以最终答案是:Joseph Ball

#

#

# Question: 《大白鲨》和《皇家赌场》的导演是同一个国家的吗?

#

# 这里需要进一步的问题吗:是的。

# 追问:谁是《大白鲨》的导演?

# 中间答案:《大白鲨》的导演是Steven Spielberg。

# 追问:Steven Spielberg来自哪里?

# 中间答案:美国。

# 追问:谁是《皇家赌场》的导演?

# 中间答案:《皇家赌场》的导演是Martin Campbell。

# 追问:Martin Campbell来自哪里?

# 中间答案:新西兰。

# 所以最终答案是:不是

#

# Question: 玛丽·波尔·华盛顿的父亲是谁?示例选择器 Example Selectors:如果你有大量的参考示例,就得选择哪些要包含在提示中。最好还是根据某种条件或者规则来自动选择,Example Selector 是负责这个任务的类。

BaseExampleSelector 定义如下:

1

2

3

4

5

6class BaseExampleSelector(ABC):

"""用于选择包含在提示中的示例的接口。"""

def select_examples(self, input_variables: Dict[str, str]) -> List[dict]:

"""根据输入选择要使用的示例。"""ABC是 Python 中的abc模块中的一个缩写,它表示 “Abstract Base Class”(抽象基类)。在 Python 中,抽象基类用于定义其他类必须遵循的基本接口或蓝图,但不能直接实例化。其主要目的是为了提供一种形式化的方式来定义和检查子类的接口。使用抽象基类的几点关键信息:- 抽象方法:在抽象基类中,你可以定义抽象方法,它没有实现(也就是说,它没有方法体)。任何继承该抽象基类的子类都必须提供这些抽象方法的实现。

- 不能直接实例化:你不能直接创建抽象基类的实例。试图这样做会引发错误。它们的主要目的是为了被继承,并在子类中实现其方法。

- 强制子类实现:如果子类没有实现所有的抽象方法,那么试图实例化该子类也会引发错误。这确保了继承抽象基类的所有子类都遵循了预定的接口。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67# 导入需要的模块和类

from langchain.prompts.example_selector import SemanticSimilarityExampleSelector

from langchain.vectorstores import Chroma

from langchain_openai import OpenAIEmbeddings

from langchain.prompts import FewShotPromptTemplate, PromptTemplate

# 定义一个提示模板

example_prompt = PromptTemplate(

input_variables=["input", "output"], # 输入变量的名字

template="Input: {input}\nOutput: {output}", # 实际的模板字符串

)

# 这是一个假设的任务示例列表,用于创建反义词

examples = [

{"input": "happy", "output": "sad"},

{"input": "tall", "output": "short"},

{"input": "energetic", "output": "lethargic"},

{"input": "sunny", "output": "gloomy"},

{"input": "windy", "output": "calm"},

]

# 从给定的示例中创建一个语义相似性选择器

example_selector = SemanticSimilarityExampleSelector.from_examples(

examples, # 可供选择的示例列表

OpenAIEmbeddings(), # 用于生成嵌入向量的嵌入类,用于衡量语义相似性

Chroma, # 用于存储嵌入向量并进行相似性搜索的 VectorStore 类

k=1 # 要生成的示例数量

)

# 创建一个 FewShotPromptTemplate 对象

similar_prompt = FewShotPromptTemplate(

example_selector=example_selector, # 提供一个 ExampleSelector 替代示例

example_prompt=example_prompt, # 前面定义的提示模板

prefix="Give the antonym of every input", # 前缀模板

suffix="Input: {adjective}\nOutput:", # 后缀模板

input_variables=["adjective"], # 输入变量的名字

)

# 输入是一种感受,所以应该选择 happy/sad 的示例。

print(similar_prompt.format(adjective="worried"))

# Give the antonym of every input

#

# Input: happy

# Output: sad

#

# Input: worried

# Output:

# 输入是一种度量,所以应该选择 tall/short的示例。

print(similar_prompt.format(adjective="long"))

# Give the antonym of every input

#

# Input: tall

# Output: short

#

# Input: long

# Output:

print(similar_prompt.format(adjective="rain"))

# Give the antonym of every input

#

# Input: windy

# Output: calm

#

# Input: rain

# Output:

1.3 模型输出Output Parser

语言模型的输出是文本。但很多时候,您可能希望获得比纯文本更结构化的信息。这就是输出解析器的价值所在。输出解析器是帮助结构化语言模型响应的类。它们必须实现两种主要方法:

“获取格式指令”:返回一个包含有关如何格式化语言模型输出的字符串的方法。

“解析”:接受一个字符串(假设为来自语言模型的响应),并将其解析成某种结构。

然后还有一种可选方法:

- “使用提示进行解析”:接受一个字符串(假设为来自语言模型的响应)和一个提示(假设为生成此响应的提示),并将其解析成某种结构。在需要重新尝试或修复输出,并且需要从提示中获取信息以执行此操作时,通常会提供提示。

1.3.1 列表解析List Parser

当您想要返回一个逗号分隔的项目列表时,可以使用此输出解析器。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34from langchain.output_parsers import CommaSeparatedListOutputParser

from langchain.prompts import PromptTemplate, ChatPromptTemplate, HumanMessagePromptTemplate

from langchain_openai import OpenAI

# 创建一个输出解析器,用于处理带逗号分隔的列表输出

output_parser = CommaSeparatedListOutputParser()

# 获取格式化指令,该指令告诉模型如何格式化其输出

format_instructions = output_parser.get_format_instructions()

# 创建一个提示模板,它会基于给定的模板和变量来生成提示

prompt = PromptTemplate(

template="List five {subject}.\n{format_instructions}", # 模板内容

input_variables=["subject"], # 输入变量

partial_variables={"format_instructions": format_instructions} # 预定义的变量,这里我们传入格式化指令

)

# 使用提示模板和给定的主题来格式化输入

_input = prompt.format(subject="ice cream flavors")

print(_input)

# List five ice cream flavors.

# Your response should be a list of comma separated values, eg: `foo, bar, baz` or `foo,bar,baz`

llm = OpenAI(temperature=0)

output = llm.invoke(_input)

print(output)

# 1. Chocolate

# 2. Vanilla

# 3. Strawberry

# 4. Mint chocolate chip

# 5. Cookies and cream

# 使用之前创建的输出解析器来解析模型的输出

output_parser.parse(output) # ['1. Chocolate\n2. Vanilla\n3. Strawberry\n4. Mint chocolate chip\n5. Cookies and cream']

1.3.2 日期解析Datatime Parser

1 | from langchain.output_parsers import DatetimeOutputParser |

2、Chains

对于简单的大模型应用,单独使用语言模型(LLMs)是可以的。

但更复杂的大模型应用需要将

LLMs和Chat Models链接在一起 - 要么彼此链接,要么与其他组件链接。- LangChain 为这种“链式”应用程序提供了

Chain接口。 - LangChain 以通用方式定义了

Chain,它是对组件进行调用序列的集合,其中可以包含其他链。

- LangChain 为这种“链式”应用程序提供了

Chain Class 基类(代码实现:https://github.com/langchain-ai/langchain/blob/master/libs/langchain/langchain/chains/base.py):

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52# 类继承关系:Chain --> <name>Chain # Examples: LLMChain, MapReduceChain, RouterChain

# 定义一个名为Chain的基础类

class Chain(Serializable, Runnable[Dict[str, Any], Dict[str, Any]], ABC):

"""为创建结构化的组件调用序列的抽象基类。

链应该用来编码对组件的一系列调用,如模型、文档检索器、其他链等,并为此序列提供一个简单的接口。

Chain接口使创建应用程序变得容易,这些应用程序是:

- 有状态的:给任何Chain添加Memory可以使它具有状态,

- 可观察的:向Chain传递Callbacks来执行额外的功能,如记录,这在主要的组件调用序列之外,

- 可组合的:Chain API足够灵活,可以轻松地将Chains与其他组件结合起来,包括其他Chains。

链公开的主要方法是:

- `__call__`:链是可以调用的。`__call__`方法是执行Chain的主要方式。它将输入作为一个字典接收,并返回一个字典输出。

- `run`:一个方便的方法,它以args/kwargs的形式接收输入,并将输出作为字符串或对象返回。这种方法只能用于一部分链,不能像`__call__`那样返回丰富的输出。

"""

# 调用链

def invoke(

self, input: Dict[str, Any], config: Optional[runnableConfig] = None

) -> Dict[str, Any]:

"""传统调用方法。"""

return self(input, **(config or {}))

# 链的记忆,保存状态和变量

memory: Optional[BaseMemory] = None

"""可选的内存对象,默认为None。

内存是一个在每个链的开始和结束时被调用的类。在开始时,内存加载变量并在链中传递它们。在结束时,它保存任何返回的变量。

有许多不同类型的内存,请查看内存文档以获取完整的目录。"""

# 回调,可能用于链的某些操作或事件。

callbacks: Callbacks = Field(default=None, exclude=True)

"""可选的回调处理程序列表(或回调管理器)。默认为None。

在对链的调用的生命周期中,从on_chain_start开始,到on_chain_end或on_chain_error结束,都会调用回调处理程序。

每个自定义链可以选择调用额外的回调方法,详细信息请参见Callback文档。"""

# 是否详细输出模式

verbose: bool = Field(default_factory=_get_verbosity)

"""是否以详细模式运行。在详细模式下,一些中间日志将打印到控制台。默认值为`langchain.verbose`。"""

# 与链关联的标签

tags: Optional[List[str]] = None

"""与链关联的可选标签列表,默认为None。

这些标签将与对这个链的每次调用关联起来,并作为参数传递给在`callbacks`中定义的处理程序。

你可以使用这些来例如识别链的特定实例与其用例。"""

# 与链关联的元数据

metadata: Optional[Dict[str, Any]] = None

"""与链关联的可选元数据,默认为None。

这些元数据将与对这个链的每次调用关联起来,并作为参数传递给在`callbacks`中定义的处理程序。

你可以使用这些来例如识别链的特定实例与其用例。"""

2.1 LLMChain

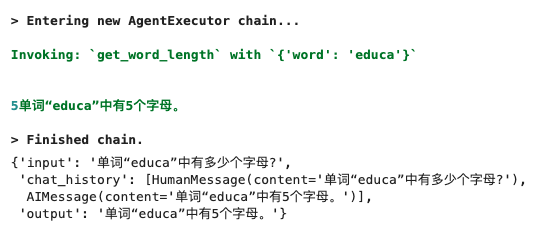

LLMChain 是 LangChain 中最简单的链,作为其他复杂 Chains 和 Agents 的内部调用,被广泛应用。

一个LLMChain由PromptTemplate和语言模型(LLM or Chat Model)组成。它使用直接传入(或 memory 提供)的 key-value 来规范化生成 Prompt Template(提示模板),并将生成的 prompt (格式化后的字符串)传递给大模型,并返回大模型输出。

![image-20250602135449611]()

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28# from langchain_openai import OpenAI

# from langchain.prompts import PromptTemplate

# llm = OpenAI(model_name="gpt-3.5-turbo-instruct", temperature=0.9, max_tokens=500)

# 【新增】ChatOpenAI调用方式,使用gpt-4o-mini模型

from langchain_openai import ChatOpenAI

from langchain.prompts import PromptTemplate

llm = ChatOpenAI(model_name="gpt-4o-mini", temperature=0.9, max_tokens=500)

prompt = PromptTemplate(

input_variables=["product"],

template="给制造{product}的有限公司取10个好名字,并给出完整的公司名称",

)

from langchain.chains import LLMChain

chain = LLMChain(llm=llm, prompt=prompt)

print(chain.invoke({

'product': "性能卓越的GPU"

}))

# {'product': '性能卓越的GPU', 'text': '以下是十个适合制造性能卓越的GPU公司的名称及其完整的公司名称:\n\n1. **极限视觉科技有限公司** \n (Limitless Vision Technology Co., Ltd.)\n\n2. **超频图形处理有限公司** \n (Overclock Graphics Processing Co., Ltd.)\n\n3. **锐视电子科技有限公司** \n (SharpSight Electronics Technology Co., Ltd.)\n\n4. **未来显卡制造有限公司** \n (Future GPU Manufacturing Co., Ltd.)\n\n5. **动能图形解决方案有限公司** \n (Kinetic Graphics Solutions Co., Ltd.)\n\n6. **超性能图形科技有限公司** \n (Ultra Performance Graphics Technology Co., Ltd.)\n\n7. **高效计算视觉有限公司** \n (Efficient Computing Vision Co., Ltd.)\n\n8. **极致图形创新有限公司** \n (Ultimate Graphics Innovations Co., Ltd.)\n\n9. **智绘科技有限公司** \n (SmartRender Technology Co., Ltd.)\n\n10. **顶尖图形硬件有限公司** \n (TopTier Graphics Hardware Co., Ltd.)\n\n希望这些名称能够激发您的灵感!'}

chain.verbose =True

print(chain.invoke({

'product': "性能卓越的GPU"

}))![image-20250602135815848]()

The class

LLMChainwas deprecated in LangChain 0.1.17 and will be removed in 1.0. Use :meth:~RunnableSequence, e.g.,prompt | llm`` instead.【新增】langchain 0.3版本,使用RunnableSequence替换LLMChain,并指定 output_key

2.2 Sequential Chain

串联式调用语言模型(将一个调用的输出作为另一个调用的输入)。

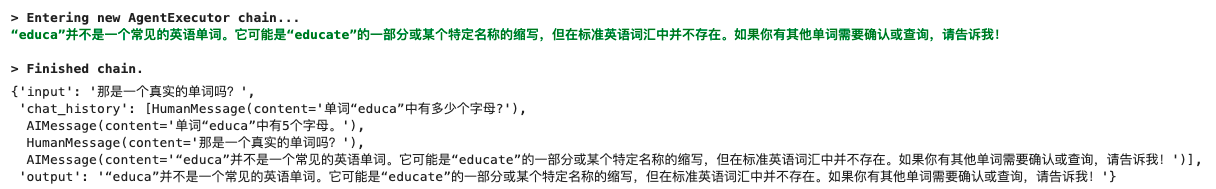

顺序链(Sequential Chain )允许用户连接多个链并将它们组合成执行特定场景的流水线(Pipeline)。有两种类型的顺序链:

SimpleSequentialChain:最简单形式的顺序链,每个步骤都具有单一输入/输出,并且一个步骤的输出是下一个步骤的输入。

![image-20250602135917506]()

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27# 使用 SimpleSequentialChain 实现戏剧摘要和评论(单输入/单输出)

# 这是一个 LLMChain,用于根据剧目的标题撰写简介。

# llm = OpenAI(temperature=0.7, max_tokens=1000)

# 【新增】ChatOpenAI调用方式,使用gpt-4o-mini模型

llm = ChatOpenAI(model_name="gpt-4o-mini", temperature=0.9, max_tokens=500)

template = """你是一位剧作家。根据戏剧的标题,你的任务是为该标题写一个简介。

标题:{title}

剧作家:以下是对上述戏剧的简介:"""

prompt_template = PromptTemplate(input_variables=["title"], template=template)

synopsis_chain = LLMChain(llm=llm, prompt=prompt_template)

# 这是一个LLMChain,用于根据剧情简介撰写一篇戏剧评论。

# llm = OpenAI(temperature=0.7, max_tokens=1000)

template = """你是《纽约时报》的戏剧评论家。根据剧情简介,你的工作是为该剧撰写一篇评论。

剧情简介:

{synopsis}

以下是来自《纽约时报》戏剧评论家对上述剧目的评论:"""

prompt_template = PromptTemplate(input_variables=["synopsis"], template=template)

review_chain = LLMChain(llm=llm, prompt=prompt_template)![image-20250602140209126]()

1

2

3

4

5# 这是一个SimpleSequentialChain,按顺序运行这两个链

from langchain.chains import SimpleSequentialChain

overall_chain = SimpleSequentialChain(chains=[synopsis_chain, review_chain], verbose=True)

review = overall_chain.invoke("三体人不是无法战胜的")![image-20250602140334751]()

1

review = overall_chain.invoke("星球大战第九季")

![image-20250602140356388]()

SequentialChain:更通用形式的顺序链,允许多个输入/输出。

![image-20250602140437490]()

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27# 使用 SequentialChain 实现戏剧摘要和评论(多输入/多输出)

# # 这是一个 LLMChain,根据剧名和设定的时代来撰写剧情简介。

# llm = OpenAI(temperature=.7, max_tokens=1000)

# # 【新增】ChatOpenAI调用方式,使用gpt-4o-mini模型

llm = ChatOpenAI(model_name="gpt-4o-mini", temperature=0.9, max_tokens=500)

template = """你是一位剧作家。根据戏剧的标题和设定的时代,你的任务是为该标题写一个简介。

标题:{title}

时代:{era}

剧作家:以下是对上述戏剧的简介:"""

prompt_template = PromptTemplate(input_variables=["title", "era"], template=template)

# output_key

synopsis_chain = LLMChain(llm=llm, prompt=prompt_template, output_key="synopsis", verbose=True)

# 这是一个LLMChain,用于根据剧情简介撰写一篇戏剧评论。

template = """你是《纽约时报》的戏剧评论家。根据该剧的剧情简介,你需要撰写一篇关于该剧的评论。

剧情简介:

{synopsis}

来自《纽约时报》戏剧评论家对上述剧目的评价:"""

prompt_template = PromptTemplate(input_variables=["synopsis"], template=template)

review_chain = LLMChain(llm=llm, prompt=prompt_template, output_key="review", verbose=True)1

2

3

4

5

6

7

8

9from langchain.chains import SequentialChain

m_overall_chain = SequentialChain(

chains=[synopsis_chain, review_chain],

input_variables=["era", "title"],

# Here we return multiple variables

output_variables=["synopsis", "review"],

verbose=True)

m_overall_chain.invoke({"title":"三体人不是无法战胜的", "era": "二十一世纪的新中国"})![image-20250602140657235]()

2.3 Transform Chain

Transform Chain可实现快捷处理超长文本:

![image-20250602141311742]()

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26from langchain.chains import TransformChain, LLMChain, SimpleSequentialChain

from langchain_openai import OpenAI

from langchain.prompts import PromptTemplate

from langchain_core.runnables import RunnableSequence

with open("../tests/the_old_man_and_the_sea.txt", encoding='utf-8') as f:

novel_text = f.read()

print(novel_text)

len(novel_text) # 47867

# 定义一个转换函数,输入是一个字典,输出也是一个字典。

def transform_func(inputs: dict) -> dict:

# 从输入字典中获取"text"键对应的文本。

text = inputs["text"]

# 使用split方法将文本按照"\n\n"分隔为多个段落,并只取前三个,然后再使用"\n\n"将其连接起来。

shortened_text = "\n\n".join(text.split("\n\n")[:3])

# 返回裁剪后的文本,用"output_text"作为键。

return {"output_text": shortened_text}

# 使用上述转换函数创建一个TransformChain对象。

# 定义输入变量为["text"],输出变量为["output_text"],并指定转换函数为transform_func。

transform_chain = TransformChain(

input_variables=["text"], output_variables=["output_text"], transform=transform_func

)

transformed_novel = transform_chain.invoke(novel_text)

print(transformed_novel['text'])1

2

3

4

5

6

7

8template = """总结下面文本:

{output_text}

总结:"""

prompt = PromptTemplate(input_variables=["output_text"], template=template)

llm_chain = LLMChain(llm=OpenAI(), prompt=prompt, verbose=True)

llm_chain.invoke(transformed_novel['output_text'][:1000])![image-20250602141653310]()

1

2

3# 使用 Sequential Chain 编排

sequential_chain = SimpleSequentialChain(chains=[transform_chain, llm_chain])

sequential_chain.invoke(novel_text[:100])![image-20250602141842013]()

2.4 Router Chain

Router Chain可实现条件判断的大模型调用。

这段代码构建了一个可定制的链路系统,用户可以提供不同的输入提示,并根据这些提示获取适当的响应。

主要逻辑:从

prompt_infos创建多个LLMChain对象,并将它们保存在一个字典中,然后创建一个默认的ConversationChain,最后创建一个带有路由功能的MultiPromptChain。![image-20250602142011375]()

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52from langchain.chains.router import MultiPromptChain

from langchain_openai import OpenAI

from langchain.chains import ConversationChain

from langchain.chains.llm import LLMChain

from langchain.prompts import PromptTemplate

physics_template = """你是一位非常聪明的物理教授。

你擅长以简洁易懂的方式回答关于物理的问题。

当你不知道某个问题的答案时,你会坦诚承认。

这是一个问题:

{input}"""

math_template = """你是一位很棒的数学家。你擅长回答数学问题。

之所以如此出色,是因为你能够将难题分解成各个组成部分,

先回答这些组成部分,然后再将它们整合起来回答更广泛的问题。

这是一个问题:

{input}"""

prompt_infos = [

{

"name": "物理",

"description": "适用于回答物理问题",

"prompt_template": physics_template,

},

{

"name": "数学",

"description": "适用于回答数学问题",

"prompt_template": math_template,

},

]

llm = OpenAI(model_name="gpt-3.5-turbo-instruct")

# 创建一个空的目标链字典,用于存放根据prompt_infos生成的LLMChain。

destination_chains = {}

# 遍历prompt_infos列表,为每个信息创建一个LLMChain。

for p_info in prompt_infos:

name = p_info["name"] # 提取名称

prompt_template = p_info["prompt_template"] # 提取模板

# 创建PromptTemplate对象

prompt = PromptTemplate(template=prompt_template, input_variables=["input"])

# 使用上述模板和llm对象创建LLMChain对象

chain = LLMChain(llm=llm, prompt=prompt)

# 将新创建的chain对象添加到destination_chains字典中

destination_chains[name] = chain

# 创建一个默认的ConversationChain

default_chain = ConversationChain(llm=llm, output_key="text")

type(default_chain) # langchain.chains.conversation.base.ConversationChain使用 LLMRouterChain 实现条件判断调用:这段代码定义了一个chain对象(LLMRouterChain),该对象首先使用router_chain来决定哪个destination_chain应该被执行,如果没有合适的目标链,则默认使用default_chain。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81from langchain.chains.router.llm_router import LLMRouterChain, RouterOutputParser

from langchain.chains.router.multi_prompt_prompt import MULTI_PROMPT_ROUTER_TEMPLATE

# 从prompt_infos中提取目标信息并将其转化为字符串列表

destinations = [f"{p['name']}: {p['description']}" for p in prompt_infos]

# 使用join方法将列表转化为字符串,每个元素之间用换行符分隔

destinations_str = "\n".join(destinations)

# 根据MULTI_PROMPT_ROUTER_TEMPLATE格式化字符串和destinations_str创建路由模板

router_template = MULTI_PROMPT_ROUTER_TEMPLATE.format(destinations=destinations_str)

# 创建路由的PromptTemplate

router_prompt = PromptTemplate(

template=router_template,

input_variables=["input"],

output_parser=RouterOutputParser(),

)

# 使用上述路由模板和llm对象创建LLMRouterChain对象

router_chain = LLMRouterChain.from_llm(llm, router_prompt)

print(destinations) # ['物理: 适用于回答物理问题', '数学: 适用于回答数学问题']

print(destinations_str)

# 物理: 适用于回答物理问题

# 数学: 适用于回答数学问题

print(MULTI_PROMPT_ROUTER_TEMPLATE)

# Given a raw text input to a language model select the model prompt best suited for the input. You will be given the names of the available prompts and a description of what the prompt is best suited for. You may also revise the original input if you think that revising it will ultimately lead to a better response from the language model.

#

# << FORMATTING >>

# Return a markdown code snippet with a JSON object formatted to look like:

# ```json

# {{{{

# "destination": string \ name of the prompt to use or "DEFAULT"

# "next_inputs": string \ a potentially modified version of the original input

# }}}}

# ```

#

# REMEMBER: "destination" MUST be one of the candidate prompt names specified below OR it can be "DEFAULT" if the input is not well suited for any of the candidate prompts.

# REMEMBER: "next_inputs" can just be the original input if you don't think any modifications are needed.

#

# << CANDIDATE PROMPTS >>

# {destinations}

#

# << INPUT >>

# {{input}}

#

# << OUTPUT (must include ```json at the start of the response) >>

# << OUTPUT (must end with ```) >>

print(router_template)

# Given a raw text input to a language model select the model prompt best suited for the input. You will be given the names of the available prompts and a description of what the prompt is best suited for. You may also revise the original input if you think that revising it will ultimately lead to a better response from the language model.

#

# << FORMATTING >>

# Return a markdown code snippet with a JSON object formatted to look like:

# ```json

# {{

# "destination": string \ name of the prompt to use or "DEFAULT"

# "next_inputs": string \ a potentially modified version of the original input

# }}

# ```

#

# REMEMBER: "destination" MUST be one of the candidate prompt names specified below OR it can be "DEFAULT" if the input is not well suited for any of the candidate prompts.

# REMEMBER: "next_inputs" can just be the original input if you don't think any modifications are needed.

#

# << CANDIDATE PROMPTS >>

# 物理: 适用于回答物理问题

# 数学: 适用于回答数学问题

#

# << INPUT >>

# {input}

#

# << OUTPUT (must include ```json at the start of the response) >>

# << OUTPUT (must end with ```) >>

# 创建MultiPromptChain对象,其中包含了路由链,目标链和默认链。

chain = MultiPromptChain(

router_chain=router_chain,

destination_chains=destination_chains,

default_chain=default_chain,

verbose=True,

)

print(chain.invoke("黑体辐射是什么??"))![image-20250602145924974]()

1

2router_chain.verbose = True

print(chain.invoke("黑洞是什么?"))![image-20250602150044197]()

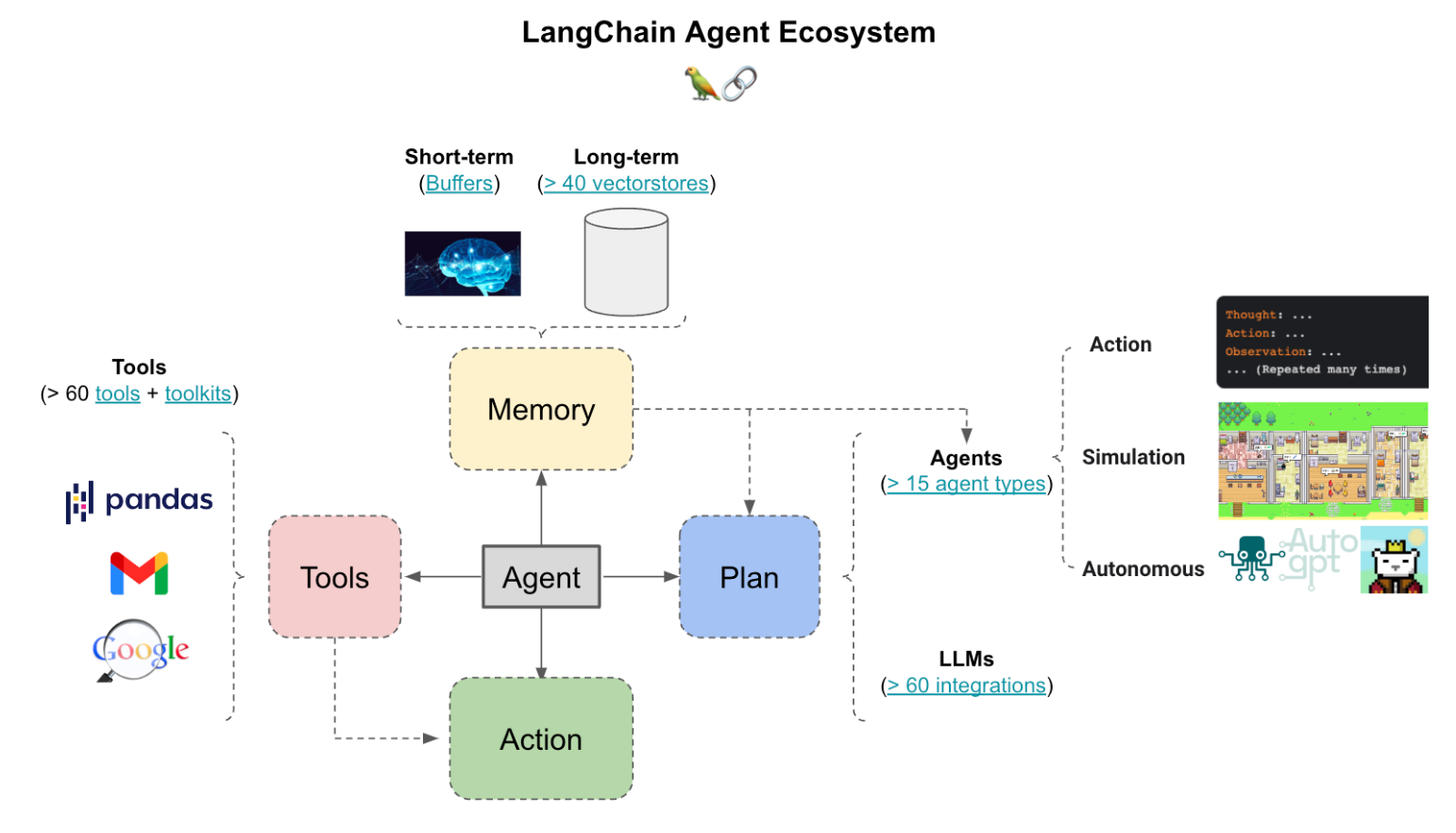

3、Memory

大多数LLM应用都具有对话界面。对话的一个重要组成部分是能够引用先前在对话中介绍过的信息。至少,一个对话系统应该能够直接访问一些过去消息的窗口。更复杂的系统将需要拥有一个不断更新的世界模型,使其能够保持关于实体及其关系的信息。

我们将存储过去交互信息的能力称为“记忆(Memory)”。

LangChain提供了许多用于向应用/系统中添加 Memory 的实用工具。这些工具可以单独使用,也可以无缝地集成到链中。

一个记忆系统(Memory System)需要支持两个基本操作:读取(READ)和写入(WRITE)。

每个链都定义了一些核心执行逻辑,并期望某些输入。其中一些输入直接来自用户,但有些输入可能来自 Memory。

在一个典型 Chain 的单次运行中,将与其 Memory System 进行至少两次交互:

- 在接收到初始用户输入之后,在执行核心逻辑之前,链将从其 Memory 中读取并扩充用户输入。

- 在执行核心逻辑之后但在返回答案之前,一个链条将把当前运行的输入和输出写入 Memory ,以便在未来的运行中可以引用它们。

![image-20250602153620450]()

BaseMemory Class基类(代码实现:https://github.com/langchain-ai/langchain/blob/master/libs/langchain/langchain/schema/memory.py):

- 类继承关系:BaseMemory –> BaseChatMemory –> <name>Memory # Examples: ZepMemory, MotorheadMemory

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45# 定义一个名为BaseMemory的基础类

class BaseMemory(Serializable, ABC):

"""用于Chains中的内存的抽象基类。

这里的内存指的是Chains中的状态。内存可以用来存储关于Chain的过去执行的信息,

并将该信息注入到Chain的未来执行的输入中。例如,对于会话型Chains,内存可以用来

存储会话,并自动将它们添加到未来的模型提示中,以便模型具有必要的上下文来连贯地

响应最新的输入。"""

# 定义一个名为Config的子类

class Config:

"""为此pydantic对象配置。

Pydantic是一个Python库,用于数据验证和设置管理,主要基于Python类型提示。

"""

# 允许在pydantic模型中使用任意类型。这通常用于允许复杂的数据类型。

arbitrary_types_allowed = True

# 下面是一些必须由子类实现的方法:

# 定义一个属性,它是一个抽象方法。任何从BaseMemory派生的子类都需要实现此方法。

# 此方法应返回该内存类将添加到链输入的字符串键。

def memory_variables(self) -> List[str]:

"""获取此内存类将添加到链输入的字符串键。"""

# 定义一个抽象方法。任何从BaseMemory派生的子类都需要实现此方法。

# 此方法基于给定的链输入返回键值对。

def load_memory_variables(self, inputs: Dict[str, Any]) -> Dict[str, Any]:

"""根据给链的文本输入返回键值对。"""

# 定义一个抽象方法。任何从BaseMemory派生的子类都需要实现此方法。

# 此方法将此链运行的上下文保存到内存。

def save_context(self, inputs: Dict[str, Any], outputs: Dict[str, str]) -> None:

"""保存此链运行的上下文到内存。"""

# 定义一个抽象方法。任何从BaseMemory派生的子类都需要实现此方法。

# 此方法清除内存内容。

def clear(self) -> None:

"""清除内存内容。"""BaseChatMessageHistory Class基类:

- 类继承关系:BaseChatMessageHistory –> <name>ChatMessageHistory # Example: ZepChatMessageHistory

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39# 定义一个名为BaseChatMessageHistory的基础类

class BaseChatMessageHistory(ABC):

"""聊天消息历史记录的抽象基类。"""

# 在内存中存储的消息列表

messages: List[BaseMessage]

# 定义一个add_user_message方法,它是一个方便的方法,用于将人类消息字符串添加到存储区。

def add_user_message(self, message: str) -> None:

"""为存储添加一个人类消息字符串的便捷方法。

参数:

message: 人类消息的字符串内容。

"""

self.add_message(HumanMessage(content=message))

# 定义一个add_ai_message方法,它是一个方便的方法,用于将AI消息字符串添加到存储区。

def add_ai_message(self, message: str) -> None:

"""为存储添加一个AI消息字符串的便捷方法。

参数:

message: AI消息的字符串内容。

"""

self.add_message(AIMessage(content=message))

# 抽象方法,需要由继承此基类的子类来实现。

def add_message(self, message: BaseMessage) -> None:

"""将Message对象添加到存储区。

参数:

message: 要存储的BaseMessage对象。

"""

raise NotImplementedError()

# 抽象方法,需要由继承此基类的子类来实现。

def clear(self) -> None:

"""从存储中删除所有消息"""

3.1 ConversationBufferMemory

ConversationBufferMemory可以用来存储消息,并将消息提取到一个变量中。1

2

3

4

5

6

7

8

9

10

11

12from langchain_openai import OpenAI

from langchain.chains import ConversationChain

from langchain.memory import ConversationBufferMemory

llm = OpenAI(temperature=0)

conversation = ConversationChain(

llm=llm,

verbose=True,

memory=ConversationBufferMemory()

)

conversation.predict(input="你好呀!")![image-20250602165004160]()

1

conversation.predict(input="你为什么叫小米?跟雷军有关系吗?")

![image-20250602165033379]()

3.2 ConversationBufferWindowMemory

ConversationBufferWindowMemory会在时间轴上保留对话的交互列表。它只使用最后 K 次交互。这对于保持最近交互的滑动窗口非常有用,以避免缓冲区过大。1

2

3

4

5

6

7

8

9from langchain.memory import ConversationBufferWindowMemory

conversation_with_summary = ConversationChain(

llm=OpenAI(temperature=0, max_tokens=1000),

# We set a low k=2, to only keep the last 2 interactions in memory

memory=ConversationBufferWindowMemory(k=2),

verbose=True

)

conversation_with_summary.predict(input="嗨,你最近过得怎么样?")![image-20250602165159308]()

1

conversation_with_summary.predict(input="你最近学到什么新知识了?")

![image-20250602165218884]()

1

conversation_with_summary.predict(input="展开讲讲?")

![image-20250602165238480]()

1

2# 注意:第一句对话从 Memory 中移除了.

conversation_with_summary.predict(input="如果要构建聊天机器人,具体要用什么自然语言处理技术?")![image-20250602165302749]()

1

conversation_with_summary.__dict__

![image-20250602165339026]()

3.3 ConversationSummaryBufferMemory

ConversationSummaryBufferMemory在内存中保留了最近的交互缓冲区,但不仅仅是完全清除旧的交互,而是将它们编译成摘要并同时使用。与以前的实现不同的是,它使用token长度而不是交互次数来确定何时清除交互。1

2

3

4

5from langchain.memory import ConversationSummaryBufferMemory

memory = ConversationSummaryBufferMemory(llm=llm, max_token_limit=10)

memory.save_context({"input": "嗨,你最近过得怎么样?"}, {"output": " 嗨!我最近过得很好,谢谢你问。我最近一直在学习新的知识,并且正在尝试改进自己的性能。我也在尝试更多的交流,以便更好地了解人类的思维方式。"})

memory.save_context({"input": "你最近学到什么新知识了?"}, {"output": " 最近我学习了有关自然语言处理的知识,以及如何更好地理解人类的语言。我还学习了有关机器学习的知识,以及如何使用它来改善自己的性能。"})1

2

3memory.load_memory_variables({}) # {'history': 'System: \nThe human asks how the AI has been doing lately. The AI responds that it has been doing well, thanks for asking. It has been learning new knowledge and trying to improve its performance, including in the areas of natural language processing and machine learning. It has also been trying to communicate more in order to better understand human thinking.'}

print(memory.load_memory_variables({})['history']) # System: The human asks how the AI has been doing lately. The AI responds that it has been doing well, thanks for asking. It has been learning new knowledge and trying to improve its performance, including in the areas of natural language processing and machine learning. It has also been trying to communicate more in order to better understand human thinking.

4、Data Conneciton

4.1 Document Loaders

使用文档加载器从源中加载数据作为文档。一个文档是一段文字和相关的元数据。

Document类:这段代码定义了一个名为

Document的类,允许用户与文档的内容进行交互,可以查看文档的段落、摘要,以及使用查找功能来查询文档中的特定字符串。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45# 基于BaseModel定义的文档类。

class Document(BaseModel):

"""接口,用于与文档进行交互。"""

# 文档的主要内容。

page_content: str

# 用于查找的字符串。

lookup_str: str = ""

# 查找的索引,初次默认为0。

lookup_index = 0

# 用于存储任何与文档相关的元数据。

metadata: dict = Field(default_factory=dict)

def paragraphs(self) -> List[str]:

"""页面的段落列表。"""

# 使用"\n\n"将内容分割为多个段落。

return self.page_content.split("\n\n")

def summary(self) -> str:

"""页面的摘要(即第一段)。"""

# 返回第一个段落作为摘要。

return self.paragraphs[0]

# 这个方法模仿命令行中的查找功能。

def lookup(self, string: str) -> str:

"""在页面中查找一个词,模仿cmd-F功能。"""

# 如果输入的字符串与当前的查找字符串不同,则重置查找字符串和索引。

if string.lower() != self.lookup_str:

self.lookup_str = string.lower()

self.lookup_index = 0

else:

# 如果输入的字符串与当前的查找字符串相同,则查找索引加1。

self.lookup_index += 1

# 找出所有包含查找字符串的段落。

lookups = [p for p in self.paragraphs if self.lookup_str in p.lower()]

# 根据查找结果返回相应的信息。

if len(lookups) == 0:

return "No Results"

elif self.lookup_index >= len(lookups):

return "No More Results"

else:

result_prefix = f"(Result {self.lookup_index + 1}/{len(lookups)})"

return f"{result_prefix} {lookups[self.lookup_index]}"BaseLoader类定义:

BaseLoader类定义了如何从不同的数据源加载文档,并提供了一个可选的方法来分割加载的文档。使用这个类作为基础,开发者可以为特定的数据源创建自定义的加载器,并确保所有这些加载器都提供了加载数据的方法。load_and_split方法还提供了一个额外的功能,可以根据需要将加载的文档分割为更小的块。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23# 基础加载器类。

class BaseLoader(ABC):

"""基础加载器类定义。"""

# 抽象方法,所有子类必须实现此方法。

def load(self) -> List[Document]:

"""加载数据并将其转换为文档对象。"""

# 该方法可以加载文档,并将其分割为更小的块。

def load_and_split(

self, text_splitter: Optional[TextSplitter] = None

) -> List[Document]:

"""加载文档并分割成块。"""

# 如果没有提供特定的文本分割器,使用默认的字符文本分割器。

if text_splitter is None:

_text_splitter: TextSplitter = RecursiveCharacterTextSplitter()

else:

_text_splitter = text_splitter

# 先加载文档。

docs = self.load()

# 然后使用_text_splitter来分割每一个文档。

return _text_splitter.split_documents(docs)

使用 TextLoader 加载 Txt 文件

基于文件格式的内置Loaders: https://python.langchain.com/docs/modules/data_connection/document_loaders/:

1

2

3

4

5

6from langchain.document_loaders import TextLoader

docs = TextLoader('../tests/state_of_the_union.txt',encoding='utf-8').load()

type(docs[0]) # langchain_core.documents.base.Document

docs[0].page_content[:100] # 'Madam Speaker, Madam Vice President, our First Lady and Second Gentleman. Members of Congress and th'

使用 ArxivLoader 加载 ArXiv 论文

代码实现:https://github.com/langchain-ai/langchain/blob/master/libs/langchain/langchain/document_loaders/arxiv.py,`ArxivLoader` 类专门用于从Arxiv平台获取文档。用户提供一个搜索查询,然后加载器与Arxiv API交互,以检索与该查询相关的文档列表。这些文档然后以标准的Document格式返回。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29# 针对Arxiv平台的加载器类。

class ArxivLoader(BaseLoader):

"""从`Arxiv`加载基于搜索查询的文档。

此加载器负责将Arxiv的原始PDF文档转换为纯文本格式,以便于处理。

"""

# 初始化方法。

def __init__(

self,

query: str,

load_max_docs: Optional[int] = 100,

load_all_available_meta: Optional[bool] = False,

):

self.query = query

"""传递给Arxiv API进行搜索的特定查询或关键字。"""

self.load_max_docs = load_max_docs

"""从搜索中检索文档的上限。"""

self.load_all_available_meta = load_all_available_meta

"""决定是否加载与文档关联的所有元数据的标志。"""

# 基于查询获取文档的加载方法。

def load(self) -> List[Document]:

arxiv_client = ArxivAPIWrapper(

load_max_docs=self.load_max_docs,

load_all_available_meta=self.load_all_available_meta,

)

docs = arxiv_client.search(self.query)

return docsArxivLoader有以下参数:

- query:用于在

ArXiv中查找文档的文本 - load_max_docs:默认值为100。使用它来限制下载的文档数量。下载所有100个文档需要时间,因此在实验中请使用较小的数字。

- load_all_available_meta:默认值为False。默认情况下只下载最重要的字段:发布日期(文档发布/最后更新日期)、标题、作者、摘要。如果设置为True,则还会下载其他字段。

- query:用于在

以 GPT-3 论文(Language Models are Few-Shot Learners) 为例,展示如何使用

ArxivLoader。GPT-3 论文的 Arxiv 链接:https://arxiv.org/abs/2005.14165。1

2

3

4

5

6

7

8

9

10

11# 安装必要依赖包【明确版本】

!pip install arxiv==2.1.3 pymupdf==1.25.3

from langchain.document_loaders import ArxivLoader

query = "2005.14165"

docs = ArxivLoader(query=query, load_max_docs=5).load()

len(docs) # 1

docs[0].metadata # {'Published': '2020-07-22',

'Title': 'Language Models are Few-Shot Learners',

'Authors': 'Tom B. Brown, Benjamin Mann, Nick Ryder, Melanie Subbiah, Jared Kaplan, Prafulla Dhariwal, Arvind Neelakantan, Pranav Shyam, Girish Sastry, Amanda Askell, Sandhini Agarwal, Ariel Herbert-Voss, Gretchen Krueger, Tom Henighan, Rewon Child, Aditya Ramesh, Daniel M. Ziegler, Jeffrey Wu, Clemens Winter, Christopher Hesse, Mark Chen, Eric Sigler, Mateusz Litwin, Scott Gray, Benjamin Chess, Jack Clark, Christopher Berner, Sam McCandlish, Alec Radford, Ilya Sutskever, Dario Amodei',

'Summary': "Recent work has demonstrated substantial gains on many NLP tasks and\nbenchmarks by pre-training on a large corpus of text followed by fine-tuning on\na specific task. While typically task-agnostic in architecture, this method\nstill requires task-specific fine-tuning datasets of thousands or tens of\nthousands of examples. By contrast, humans can generally perform a new language\ntask from only a few examples or from simple instructions - something which\ncurrent NLP systems still largely struggle to do. Here we show that scaling up\nlanguage models greatly improves task-agnostic, few-shot performance, sometimes\neven reaching competitiveness with prior state-of-the-art fine-tuning\napproaches. Specifically, we train GPT-3, an autoregressive language model with\n175 billion parameters, 10x more than any previous non-sparse language model,\nand test its performance in the few-shot setting. For all tasks, GPT-3 is\napplied without any gradient updates or fine-tuning, with tasks and few-shot\ndemonstrations specified purely via text interaction with the model. GPT-3\nachieves strong performance on many NLP datasets, including translation,\nquestion-answering, and cloze tasks, as well as several tasks that require\non-the-fly reasoning or domain adaptation, such as unscrambling words, using a\nnovel word in a sentence, or performing 3-digit arithmetic. At the same time,\nwe also identify some datasets where GPT-3's few-shot learning still struggles,\nas well as some datasets where GPT-3 faces methodological issues related to\ntraining on large web corpora. Finally, we find that GPT-3 can generate samples\nof news articles which human evaluators have difficulty distinguishing from\narticles written by humans. We discuss broader societal impacts of this finding\nand of GPT-3 in general."}

使用 UnstructuredURLLoader 加载网页内容

使用非结构化分区函数(Unstructured)来检测MIME类型并将文件路由到适当的分区器(partitioner)。

支持两种模式运行加载程序:”single”和”elements”。如果使用”single”模式,文档将作为单个langchain Document对象返回。如果使用”elements”模式,非结构化库将把文档拆分成标题和叙述文本等元素。您可以在mode后面传入其他非结构化kwargs以应用不同的非结构化设置。

UnstructuredURLLoader 主要参数:

- urls:待加载网页 URL 列表

- continue_on_failure:默认

True,某个URL加载失败后,是否继续 - mode:默认

single,

以 ReAct 网页为例(https://react-lm.github.io/) 展示使用。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37# 安装必要依赖包【明确版本】

! pip install python-magic==0.4.27

from langchain.document_loaders import UnstructuredURLLoader

urls = [

"https://react-lm.github.io/",

]

loader = UnstructuredURLLoader(urls=urls)

data = loader.load()

data[0].metadata # {'source': 'https://react-lm.github.io/'}

print(data[0].page_content)

# ReAct: Synergizing Reasoning and Acting in Language Models

#

# Shunyu Yao,

#

# Jeffrey Zhao,

#

# Dian Yu,

#

# Nan Du,

#

# Izhak Shafran,

#

# Karthik Narasimhan,

#

# Yuan Cao

#

# [Paper]

#

# [Code]

loader = UnstructuredURLLoader(urls=urls, mode="elements")

new_data = loader.load()

new_data[0].page_content # 'ReAct: Synergizing Reasoning and Acting in Language Models'

len(new_data) # 23

new_data[1].page_content # 'Shunyu Yao,'

4.2 Document Transformers

- 一旦加载了文档,通常会希望对其进行转换以更好地适应您的应用程序。

- 最简单的例子是,您可能希望将长文档拆分为较小的块,以适应模型的上下文窗口。LangChain具有许多内置的文档转换器,可以轻松地拆分、合并、过滤和其他操作文档。

Text Splitters 文本分割器

当你想处理长篇文本时,有必要将文本分成块。听起来很简单,但这里存在着潜在的复杂性。理想情况下,你希望将语义相关的文本片段放在一起。”语义相关”的含义可能取决于文本类型。这个笔记本展示了几种实现方式。

从高层次上看,文本分割器的工作原理如下:

- 将文本分成小而有意义的块(通常是句子)。

- 开始将这些小块组合成较大的块,直到达到某个大小(通过某个函数进行测量)。

- 一旦达到该大小,使该块成为自己独立的一部分,并开始创建一个具有一定重叠(以保持上下文关系)的新文本块。

这意味着您可以沿两个不同轴向定制您的文本分割器:

- 如何拆分文字

- 如何测量块大小

使用

RecursiveCharacterTextSplitter文本分割器,该文本分割器接受一个字符列表作为参数,根据第一个字符进行切块,但如果任何切块太大,则会继续移动到下一个字符,并以此类推。默认情况下,它尝试进行切割的字符包括["\n\n", "\n", " ", ""]。除了控制可以进行切割的字符外,您还可以控制其他一些内容:- length_function:用于计算切块长度的方法。默认只计算字符数,但通常在这里传递一个令牌计数器。

- chunk_size:您的切块的最大大小(由长度函数测量)。

- chunk_overlap:切块之间的最大重叠部分。保持一定程度的重叠可以使得各个切块之间保持连贯性(例如滑动窗口)。

- add_start_index:是否在元数据中包含每个切块在原始文档中的起始位置。

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53# 加载待分割长文本

with open('../tests/state_of_the_union.txt', encoding='utf-8') as f:

state_of_the_union = f.read()

print(state_of_the_union)

# Madam Speaker, Madam Vice President, our First Lady and Second Gentleman. Members of Congress and the Cabinet. Justices of the Supreme Court. My fellow Americans.

#

# Last year COVID-19 kept us apart. This year we are finally together again.

#

# Tonight, we meet as Democrats Republicans and Independents. But most importantly as Americans.

#

# With a duty to one another to the American people to the Constitution.

#

# And with an unwavering resolve that freedom will always triumph over tyranny.

#

# Six days ago, Russia’s Vladimir Putin sought to shake the foundations of the free world thinking he could make it bend to his menacing ways. But he badly miscalculated.

#

# He thought he could roll into Ukraine and the world would roll over. Instead he met a wall of strength he never imagined.

#

# He met the Ukrainian people.

#

# From President Zelenskyy to every Ukrainian, their fearlessness, their courage, their determination, inspires the world.

#

# Groups of citizens blocking tanks with their bodies. Everyone from students to retirees teachers turned soldiers defending their homeland.

#

# In this struggle as President Zelenskyy said in his speech to the European Parliament “Light will win over darkness.” The Ukrainian Ambassador to the United States is here tonight.

#

# Let each of us here tonight in this Chamber send an unmistakable signal to Ukraine and to the world.

#

# Please rise if you are able and show that, Yes, we the United States of America stand with the Ukrainian people.

#

# Throughout our history we’ve learned this lesson when dictators do not pay a price for their aggression they cause more chaos.

#

# They keep moving.

from langchain.text_splitter import RecursiveCharacterTextSplitter

text_splitter = RecursiveCharacterTextSplitter(

chunk_size = 100,

chunk_overlap = 20,

length_function = len,

add_start_index = True,

)

docs = text_splitter.create_documents([state_of_the_union])

print(docs[0]) # page_content='Madam Speaker, Madam Vice President, our First Lady and Second Gentleman. Members of Congress and' metadata={'start_index': 0}

print(docs[1]) # page_content='of Congress and the Cabinet. Justices of the Supreme Court. My fellow Americans.' metadata={'start_index': 82}

type(docs) # list

type(docs[0]) # langchain_core.documents.base.Document

state_of_the_union[:1000] # 'Madam Speaker, Madam Vice President, our First Lady and Second Gentleman. Members of Congress and the Cabinet. Justices of the Supreme Court. My fellow Americans. \n\nLast year COVID-19 kept us apart. This year we are finally together again. \n\nTonight, we meet as Democrats Republicans and Independents. But most importantly as Americans. \n\nWith a duty to one another to the American people to the Constitution. \n\nAnd with an unwavering resolve that freedom will always triumph over tyranny. \n\nSix days ago, Russia’s Vladimir Putin sought to shake the foundations of the free world thinking he could make it bend to his menacing ways. But he badly miscalculated. \n\nHe thought he could roll into Ukraine and the world would roll over. Instead he met a wall of strength he never imagined. \n\nHe met the Ukrainian people. \n\nFrom President Zelenskyy to every Ukrainian, their fearlessness, their courage, their determination, inspires the world. \n\nGroups of citizens blocking tanks with their bodies. Every'

metadatas = [{"document": 1}, {"document": 2}]

documents = text_splitter.create_documents([state_of_the_union, state_of_the_union], metadatas=metadatas)

print(documents[0]) # page_content='Madam Speaker, Madam Vice President, our First Lady and Second Gentleman. Members of Congress and' metadata={'document': 1, 'start_index': 0}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74# 分割代码

from langchain.text_splitter import Language

# 支持编程语言的完整列表

[e.value for e in Language]

#['cpp',

# 'go',

# 'java',

# 'kotlin',

# 'js',

# 'ts',

# 'php',

# 'proto',

# 'python',

# 'rst',

# 'ruby',

# 'rust',

# 'scala',

# 'swift',

# 'markdown',

# 'latex',

# 'html',

# 'sol',

# 'csharp',

# 'cobol',

# 'c',

# 'lua',

# 'perl',

# 'haskell']

html_text = """

<!DOCTYPE html>

<html>

<head>

<title>🦜️🔗 LangChain</title>

<style>

body {

font-family: Arial, sans-serif;

}

h1 {

color: darkblue;

}

</style>

</head>

<body>

<div>

<h1>🦜️🔗 LangChain</h1>

<p>⚡ Building applications with LLMs through composability ⚡</p>

</div>

<div>

As an open source project in a rapidly developing field, we are extremely open to contributions.

</div>

</body>

</html>

"""

html_splitter = RecursiveCharacterTextSplitter.from_language(

language=Language.HTML, chunk_size=60, chunk_overlap=0

)

html_docs = html_splitter.create_documents([html_text])

print(len(html_docs)) # 13

html_docs

# [Document(page_content='<!DOCTYPE html>\n<html>'),

# Document(page_content='<head>\n <title>🦜️🔗 LangChain</title>'),

# Document(page_content='<style>\n body {\n font-family: Aria'),

# Document(page_content='l, sans-serif;\n }\n h1 {'),

# Document(page_content='color: darkblue;\n }\n </style>\n </head'),

# Document(page_content='>'),

# Document(page_content='<body>'),

# Document(page_content='<div>\n <h1>🦜️🔗 LangChain</h1>'),

# Document(page_content='<p>⚡ Building applications with LLMs through composability ⚡'),

# Document(page_content='</p>\n </div>'),

# Document(page_content='<div>\n As an open source project in a rapidly dev'),

# Document(page_content='eloping field, we are extremely open to contributions.'),

# Document(page_content='</div>\n </body>\n</html>')]

4.3 Text Embedding Models

- Embeddings类是一个专门用于与文本嵌入模型进行交互的类。有许多嵌入模型提供者(OpenAI、Cohere、Hugging Face等)-这个类旨在为所有这些提供者提供一个标准接口。

- 嵌入将一段文本创建成向量表示。这非常有用,因为它意味着我们可以在向量空间中思考文本,并且可以执行语义搜索等操作,在向量空间中寻找最相似的文本片段。

- LangChain中基础的Embeddings类公开了两种方法:一种用于对文档进行嵌入,另一种用于对查询进行嵌入。前者输入多个文本,而后者输入单个文本。之所以将它们作为两个独立的方法,是因为某些嵌入提供者针对要搜索的文件和查询(搜索查询本身)具有不同的嵌入方法。

使用 OpenAIEmbeddings 调用 OpenAI 嵌入模型

使用 embed_documents 方法嵌入文本列表:

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16from langchain_openai import OpenAIEmbeddings

embeddings_model = OpenAIEmbeddings()

embeddings = embeddings_model.embed_documents(

[

"Hi there!",

"Oh, hello!",

"What's your name?",

"My friends call me World",

"Hello World!"

]

)

len(embeddings) # 5

len(embeddings[0]) # 1536使用 embed_query 方法嵌入问题:

1

2

3# QA场景:嵌入一段文本,以便与其他嵌入进行比较。

embedded_query = embeddings_model.embed_query("What was the name mentioned in the conversation?")

len(embedded_query) # 1536

4.4 Vector Stores

- 存储和搜索非结构化数据最常见的方法之一是将其嵌入并存储生成的嵌入向量,然后在查询时将非结构化查询进行嵌入,并检索与嵌入查询“最相似”的嵌入向量。

- 向量存储库负责为您存储已经过嵌入处理的数据并执行向量搜索。